Blender Blog – Êtes-vous CUDA capable ?

Comme bon nombre d’entre vous, j’ai été très vite séduit par la nouvelle version de Blender (2.61) et surtout l’intégration de Blender Cycles. Ce nouveau moteur de rendu de type “raytraycing” que je comparerais volontier à Yafaray ou Luxrender permet d’obtenir du photo réalisme à gogo ! On est loin du Blender Internal même si celui-ci, utilisé de manière avancée, n’a pas à rougir, loin de là ! La grande nouveauté, à mon goût, c’est de pouvoir visionner la scène 3D en mode rendu, de pouvoir paramétrer ces matériaux / lampes en live et de voir quasi instantanément le résultat.

Comme bon nombre d’entre vous, j’ai été très vite séduit par la nouvelle version de Blender (2.61) et surtout l’intégration de Blender Cycles. Ce nouveau moteur de rendu de type “raytraycing” que je comparerais volontier à Yafaray ou Luxrender permet d’obtenir du photo réalisme à gogo ! On est loin du Blender Internal même si celui-ci, utilisé de manière avancée, n’a pas à rougir, loin de là ! La grande nouveauté, à mon goût, c’est de pouvoir visionner la scène 3D en mode rendu, de pouvoir paramétrer ces matériaux / lampes en live et de voir quasi instantanément le résultat.

Nouvelle article concernant CUDA

Bon, Cycles ne va pas faire de nous, les débutants, des artistes 3D hors pair, juste parce que c’est cycles. Un apprentissage à son utilisation sera nécessaire puisque : qui dit nouveau moteur de rendu dit aussi : nouvelle méthode pour fixer les matériaux (node compositing des matériaux indispensable pour des options avancées), la non-utilisation de lampe mais de matériau émettant de la lumière (emission material), etc.

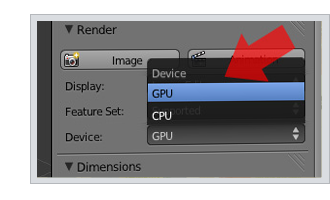

Le grand avantage de ce moteur de rendu est la prise en charge de l’accélération matériel du rendu grâce à l’utilisation du GPU (processeur graphique) plutôt que du CPU (micro-processeur). Alors qu’on se le dise, ceci va très bien fonctionner pour ceux qui possèdent un GPU NVIDIA récent.

J’ai galéré à faire fonctionner l’ensemble…

voici le bilan: J’ai 2 tours, un petit dual-core intel avec une NVIDA GeForce 9600 GT qui n’est pas toute jeune et un quad-core i7 avec un carte ATI/AMD Radeon. Impossible de faire fonctionner un des deux en mode GPU avec cycles !

Résultat? Achat de matériel NVIDIA à pluger dans le quad-core hé oui !

Le point de départ avant toute chose et d’évaluer les possibilités de votre GPU si vous êtes déjà les heureux possesseurs de matériel NVIDIA ici:

http://developer.nvidia.com/cuda-gpus

Sinon Soyez patients. Les futures versions de blender intégreront sûrement des évolutions pour les puces ATI et pour le vieux NVIDIA… songez à renouveler le matériel 🙂

Je me suis donc fait un petit cadeau de Noël : une GeForce GTX 560 Ti, CUDA 2.1 capable :D. J’ai pensé que ça allait passer sans soucis….après une petite chaleur, il a fallu un update des drivers NVIDIA depuis le site officiel pour que le mode GPU apparaisse enfin dans Blender 2.61. Depuis lors, c’est la totale ! Le GPU GTX 560 mouline les rendus Cycles 6x plus vite que mon quad-core CPU. C’est magnifique ! Le gain est tel que ça va favoriser l’utilisation de cycle au détriment des autres moteurs forcément plus poussifs en mode CPU. Sans oublier toutefois de penser aux outils (dont le choix du moteur de rendu) nécessaires à votre création. Cycles n’est pas une solution à tout.

J’espère que vous trouverez de quoi vous faire plaisir avec cycles sans passer par un achat mais….pour ceux qui ont déjà tout retourné dans tout les sens, le passage par la case magasin est un accélérateur. Testé pour vous 🙂

Bons blends à tous !

45 Comments

Bonjour, Je viens de tomber sur ce post qui date mais reste quand même d’actualité puisque pas mal de blenderiens sont bloqués avec Cycles.

Ma carte graphique une GT210 avec cuda 1.1 ne m’a pas permis de réaliser un rendu à 1 million de particules. Normal. Au dela de 20000 crash.

J’ai décidé d’investir: nouvelle machine avec un processeur I7, 12G0 de RAM, carte graphique NVIDIA GT760 avec CUDA 2.0, 1 disque dur SSD 128 Go, 1 SATA à 1To et windows 8.

Des années de galères et de frustrations, que je laisse derrière moi. Maintenant je peux afficher une scène assez complexe avec cycles avec une preview à 35 voir 50 pour un temps d’affichage de 1 à 2 seconde! J’ai pu faire un rendu,( prenant en compte le système volumique), de 5000 samples en 3h05′. Que du bonheur!

Pour vous dire que ça vaut le coup d’investir un peu, sans trouer son budget.

Le lien si vous souhaitez vous faire une idée des rendus que j’ai réalisé avec la GT760.

http://blendid.over-blog.com/

Oui le post date un peu, merci pour l’actualisation et le compte rendu ! Rien de tel que de flamber un peu d’argent dans du CUDA core 🙂

Après y’a les gens qui achètent un portable a 500 euros et qui veulent faire de la 3D avec, lol ! Et qui se rendent compte avec grand étonnement que c’est pas top, relol ! Et qui ensuite veulent acheter un GPU a 50euros et se plaignent que ca rame/plante… lololol j’ai envie de dire une fois de plus 🙂

Enfin bon le monde aujourd’hui… dur de comprendre la logique de certains ^^ C’est quand même clair qu’on peut pas rouler a la même vitesse qu’une Ferrari si on a une 2CV, pas besoin de faire l’unif pour comprendre…

Bonjour,

Utilisez vous toujours une GeForce GTX 560 Ti ou êtes vous passé à une autre carte?

P.

Bonjour Paul, oui j’utilise toujours la GTX 560 Ti. Je dois dire qu’elle se défend encore pas mal pour la réalisation de tutos dédiés aux débutants-initiés 🙂 Rapport confort prix intéressant. On m’a proposé une 580 d’occasion, je vais donc peut-être changer prochainement. Cela dit, il manque toujours cruellement un benchmarking spécifique de cartes pour l’accélération CUDA sous Blender. Ca nous aiderait bien pour un faire le choix du meilleur rapport performance/prix. Certains professionnels ayant par exemple privilégié l’utilisation de plusieurs cartes 580 en parallèle.

Je pense que cela peut s’avérer utile…

http://blenderartists.org/forum/showthread.php?331149-The-new-Cyles-GPU-2-70-Benchmark

Off topic – concerne le CPU mais c’est un complément au poste d’avant… si je l’avais vu plutôt je l’aurais mis avec.

http://blenderartists.org/forum/showthread.php?331390-Cycles-2-7x-benchmark-CPU-only

Excellent merci, toujours bon de voir du benchmarking 🙂

Good Luck !

Merci !, c’est décidé je m’achète un nouveau portable pour remplacer mon 2° ordi (un acer 7745G) et je me trouve un portable équipée d’une 675MX… ça devrait le faire !

merci en tout cas.

Hello Mike, pas de news concernant une compatibilité du mode GPU avec les cartes AMD/ATI radeon de mon côté. Je me suis résolu à utiliser la techno CUDA de Nvidia. Pas besoin de changer tout l’ordi 😀 tu trouveras peut-être une carte graphique à remplacer. Sur un portable Mac c’est conton…je ne sais pas s’il y a une solution. Good Luck !

Salut, des news concernant les carte AMD sur macbook pro?

Je suis désolé s’il y a redondance sur ce sujet, mais je n’arrive pas à passer en mode GPU avec mon macbook pro? dois je changer d’ordi?

merci pour vos réponses

Ismael,

Pourtant toutes les infos sont là…as-tu cliqué le lien sur le site de Nvidia et lu l’article attentivement ?

Nvidia dit : compute capability 1.1… donc c’est mort (min 1.3 requis).

En 1 clic avec google j’ai aussi trouvé cet article qui confirme la version 1.1 de ta carte je pense : http://philippeback.be/2012/08/nvidia-cuda-devicequery-on-13-macbook-pro-mid-2009-16-cores/

Devrais-je faire un tuto sur comment se débrouiller comme un grand avec Google 😉

Je t’invite également à lire https://www.kopilot.ch/blog/120-blender-cycles-etes-vous-cuda-capable-2, good luck !

Bonjour,

Je travaille sur un MacBook pro avec une carte graphique GeForce 9400M. Je n’arrives pas à trouver les infos précises sur la possibilité de faire des rendus GPU. J’ai installé les derniers drivers Cuda, mais rien n’y fait, dans UserPreference/System, Computer Device n’affiche que None.

Puis-je avoir de l’aide?

Merci par avance.

Ismaël

Duduff,

Désolé, je ne me risquerai pas à choisir une carte et n’ai jamais expérimenté de carte M (mobile) pour du GPU avec Blender. Quoiqu’il en soit, tu auras trouvé le lien http://developer.nvidia.com/cuda-gpus dans cet article du blog. Le dernier tableau,colonne de droite, présente les “notebook products” et il faut du 1.3 minimum dans la colonne Compute Capability. Là j’ai un peu l’impression de ré-écrire l’article du blog… mais bon 😉

Il y a donc du choix mais à voir si ça rentre dans le modèle de Mac que tu as. Pour ça je demanderai conseil au spécialiste du magasin. Attention à faire le bon choix donc. bonne chance dans cette jungle !

PS, si tu fais une expérience positive avec une carte, n’hésite pas à nous donner un retour pour les prochains 🙂 Merci !

Salut thierryK

Effectivement ThierryK et merci encore pour ta reponse. Je suis bien sur macbook pro 17″ avec une carte Nvidia Geforce 9400M , mais je viens également de me rendre compte qu’une seconde était présente, alors peut etre encore me diras tu (vous) ca ne change rien, celle ci aussi étant elle meme également incompatible. C’est une Nvidia 9600M GT 512 Mo. Alors je me permets une derniére question, quelle serais la petite perle de carte qui m’autoriserait de bonne perfo pour bibi Macbook que je le gate pour les fetes. Encore une fois un grand merci pour ta réponse. Cordialement

Salut DUDUff,

Tu as vu juste, tu es dans la mouiz! Je t’invite à lire également https://www.kopilot.ch/blog/120-blender-cycles-etes-vous-cuda-capable-2. J’en déduis que tu as un portable vu la mention m de ta carte. Pas top pour de l’accélération GPU comme tu le verras dans l’article proposé. Tu y trouveras également de l’info sommaire sur les fameux “builds” mais ça n’est pas la spécialité de kopilot qui utilise uniquement la version officielle de la Blender foundation. Ta carte n’est pas compatible avec cette version là visiblement et…pour beaucoup d’entre nous, la fin de la galère est passée par la case magasin…

Good luck!

Bonsoir ou bonjour a tous. Peut être vais je vous faire répéter mais je suis paumé complet. Je cherche, je cherche, je mets de la bonne volonté mais la je sèche. En même temps tt novice je débarque dans ces histoire de GPU CPU. Je suis sur blender 2.64 avec CUDA 5.0.37 sur un mac Os X 10.8.2 et Nvidia Geforce 9400 M 256 Mo, et je suis incapable de comprendre pourquoi j’ai ce message d’erreur : “Error CUDA device … capability 1.3 or up, found 1.1.” chiotte ou ai je merdé. Dans les pref utilisateur “syste” je retrouve bien : compute device et CUDA ainsi que ma carte graphique et lorsque je l’active dans le RENDER il y a plus personne sauf ce foutu message d’erreur. Alors c’est le genoux a terre que je vous demande la solution s’il vous plait 🙁 Cordialement. C’est pas ma carte qui n’est pas compatible je crois … ou trop faible ?! j’ai entendu parler de “Builds” pour les cartes ?! (autant dire que je ne sais pas ce que c’est. La il n’y a qu’une ame charitable pour m’aider.

Hey, merci, bonne nouvelle 😆 il s’agit de ce build http://www.graphicall.org/110 ? A tenter!

Bonsoir!

Bonne nouvelle, le dernier build (2.64.9) permet de supporter le CUDA, même pour les cartes ne supportant que le 1.1 !!!

pensez à passer en “experimental” si vous avez toujours le message d’erreur.

Hello Sckippy,

Je pense que tu pourras trouver cette réponse en utilisant les liens de l’article sur Nvidia.

Choisir une carte avec le max de coeurs CUDA puis la fréquence d’horloge la plus élevée apportera les meilleurs performances 🙂

Bonjour

Pouvez vous me dire si il vaut mieux une série gtx 6.. ou alors une ancienne série 5.. ?

Je pense pareil que sur PC,il faut du matériel CUDA compatible,soit la bonne Nvidia…n ayant pas de Mac sous le coude…difficile de t’aider plus. Les infos de cet article et les liens sur Nvidia devraient te donner des pistes,tout en t assurant que le matos est bien compatible pour ton Mac. Good luck!

Et comment fait-on sur mac? 😐

Hello, J’ai une GTX 560Ti sur seven 64bits et ça passe sans soucis…du coup…je tenterai un update des drivers de la carte avec les plus récents…sinon tout ce que j’ai galéré pour faire tourner CUDA se trouve dans l’article ci-dessus 🙂 Bizarre quand même

salut, je viens de terminer t’ont tuto du nagra que je trouve excellent, sur ma config, j’ai une gtx 560 avec seven 64 bits et cuda 4, apparemment ça passe pas quand je me met en gpu, j’ai un message d’erreur comme quoi j’ai pas le bon cuda( il demande le2.1)en s’est tu un peu plus la dessus, comment je peu faire.merci

Salut à tous

J’ai pris une Geforce GTX 560 Titaniumn une Gigabyte qu’ils ont overclocker à 900Mhz . Bref je l’ai tester sur mon 1er pc Atlhon II x4 3Ghz avec Alimentation 480w qui a grillé au bout 10 minute et fait sauter le compteur . bref j’installe la Geforce sur mon 2eme PC de travail celui là avec un Atlhon II x6 3,5Ghz et 16go Ram avec Alimentation 500w qui a griller au bout de quelques heures ! Obliger de mettre une alimentation 750w que le vendeur ma prêter jusqu’à Mardi en attendant une Alim 600W Corsair Certifié 80+gold ou chez pas quoi pour être certain d’avoir asser de rendement. Alors faites attention, éviter les alimentation Advanced 750w mais qui en réalité donne que 400w en retour , faut mieux acheter une alimentation certifié 600w qui en donne 500w en retour.

Tu n’as eu aucun souci Thierry avec tes alimentations ?

merci

même problème, même carte graphique (9600GT), mais pas les mêmes moyens : je cherche soit une solution universelle pour le CUDA 1.3 soit j’attend un nouveau pc :S

J’essayais désespérément de faire fonctionner Cycles avec ma carte graphique (étant l’heureux possesseur de la GT 540M). Une mise à jour des pilotes a suffit à régler le problème.

@wildpenguin

Oui ça à l’air supertop! Mais attention, clubic soulève quand même quelques désavantages dans leur article 😮

@megane

Attention avec l’alim oui! Il faut s’assurer que la tienne à bien de quoi alimenter la carte (certaines nécessitent 2 connecteurs plugés direct à l’alim). Si tu n’as pas déjà beaucoup de périphériques connectés (plusieurs disques-durs + DVD + blueray + une tonne de périf en USB qui tirent aussi sur l’alim) ca peut passer avec une 400W 🙂

Pour les utilisateurs de portables, ceci à l’air intéressant :

http://www.clubic.com/actualite-67926-carte-graphique-externe-asus-xg-station.html#1

Qu’en pensez-vous ? 8)

Je suis tenté par une nouvelle carte graphique (la mienne est incompatible), mais petit budget.

Mon alim est une antec HCG 400w, ce qui limite encore plus le choix !

La GTX 550 ti, 192 coeurs (c’est pas énorme, mais elle est tout de même 2,5x plus rapide qu’un i7 2600k non-OC).

Le site de nvidia recommande une alim 400w minimum pour un système équipé d’une GTX 550 ti (pas une 560, une 550), qu’en pensez-vous, est-ce vraiment chaud pour mon alim ou est-ce qu’il n’y a aucun problème ?

Tu soulèves encore une fois une question intéressante; si la prise en charge du SLI double le nombre de CUDA cores alors ça devient très excitant! Je me suis penché sur la question en creusant le web et je n’ai pas trouvé de réponse ferme. Avis bienvenus 🙂

La question de la mémoire est aussi importante en effet, j’ai d’ailleurs atteint les limites des 1024 MB GDDR5 de ma GTX 560 Ti dans le tuto “Cosmetic packaging” pour ceux qui l’on regardé jusqu’au bout 😉

Je possède un quad-core AMD et une GeForce GTS 250. En fonctionnement normal Cycles en mode CUDA demande une version 1.3 et la GTS 250 ne possède que la version 1.1…

Sur certaines version en GPU çà plante, logique… Mais sur la 43745, par exemple, çà fonctionne tout de même avec une pré-compilation. J’ai donc pu faire tourner la scène benchmark en GPU.

Mais je n’ai que 512 Mo de mémoire sur ma carte graphique et là çà coince vite.

Il faudra donc une carte graphique de génération récente et avec le plus de mémoire possible, mais le gain est purement fulgurant c’est du 10 à 20 fois plus rapide qu’avec le CPU et 8 Go de mémoire !!!

Lors d’un prochain achat d’une carte graphique il faudra faire attention au nombre de coeurs CUDA et de la qualité ainsi que de la taille de la mémoire.

La question que je me pose c’est : Est-ce que le SLI est supporté et apporte-il un plus ? Est-il donc judicieux d’acheter 2 cartes graphiques en SLI pour faire tourner Cycles ?

Voilà la question à 1 million de dollars 😉

Hé oui, on veut tjs le moins cher pour les meilleures performances…

Alors qu’on se le dise, pour avoir de la performance faut parfois savoir y mettre le prix, au risque d’être deçu par du low-cost. Dans mes tests et notamment le tuto https://www.kopilot.ch/design-and-media/blender/94-blender-cycles-cosmetic-packaging j’ai utilisé une GTX 560 Ti, CUDA 2.1. J’en suis très content et la recommande si c’est à portée de bourse. Une caractéristique à garder à portée pour des performances acceptables en fonction du prix : le nombre de CUDA cores. La 560Ti a 384 CUDA cores.

J’ai une question pratique :

Quelle carte graphique faut-il choisir pour faire fonctionner Cycles dans de bonnes conditions en y mettant le moins cher possible, en gardant une marge de progression et permettant d’avoir 2 écrans?

Je suppose que la taille et la vitesse de la mémoire est important.

Autre choix possible : 1 ou 2 cartes en SLI?

Merci Thierry

Daniel,

Visiblement il n’y a pas de GT 320m sur http://developer.nvidia.com/cuda-gpus mais ça doit être la version mobile de la GT 320 qui est CUDA 1.0 donc…pas compatible avec l’accélération GPU de Blender 2.61 😮

Changer la carte sur un portable oui c’est possible. Les versions GT XXXm étant je pense des versions pour mobile (avec le m). A trouver donc : une version mobile CUDA 1.3 sur le site NVIDIA et…un bon conseiller en magasin!

Cela dit, je ne pense pas qu’un portable soit la meilleure bête pour du rendu GPU, la ventilation (Aie ca chauffe et ca mouline!) étant beaucoup plus limitée que sur une tour. Good luck!

Bonjour j’ai une geforce Nvidia GT320m ca fonctionnerait ou pas? Mon PC est un portable je ne sais pas si on peu faire des modification dessus pour changer la carte ? Pourriez Svp me donner des infos. Le PC est un HP pavilion DV7 3165 ef il date de l année derniere je n ai pas de connaissance dans le domaine mais je kiffe trop Blender! Et si je peu faire des modif sur mon PC portable pour plus de confort avec blender alors je n hesiterais pas. Meric de votre aide

La GT 240 est équipé de cuda 1.2 et non 1.3, ça ne risque pas de fonctionner je viens de voir ça… ^^’

Je possède un i7 2600k (non oc) et une nvidia GT240 512Mo GDDR5.

Si vous savez, pouvez-vous me dire si cuda me permettrais d’obtenir de meilleurs résultats avec mon GPU qu’avec mon CPU ?

Je suis sous gnu/linux ubuntu et l’installation de cuda est assez compliqué, en tout cas je n’ai pas réussi, mais je serais près à retenter si ça en vaut la peine.

Merci.

Pas de Nvidia :/ j’ai ATI

Je me suis fait exactement le même cadeau et le rendu d’un simple objet sur 10000 passes prend 10 minutes au lieu de 4h45 avec mon core 2 duo. Soit un rendu GPU 28x plus rapide !

en effet dommage pour l’ openCL et les possesseurs de cartes ATI/AMD mais patiente…

par contre vivement le support du multi-GPU mais aussi de l’ Hybrid CPU plus GPU et la c’est le bonheur !!!!

Bonjour,

Je voulais vous envoyer un email et il semblerait que votre adresse email ne soit plus opérationnelle.

Ne validez pas ce message sur votre blog, je poste juste pour vous informer.